Preocupación en Estados Unidos: un chatbot incitó a un adolescente a matar a sus padres

La familia del menor demandó a una empresa de inteligencia artificial por exponerlo a un “producto inseguro” y pide su cierre definitivo. Qué fué lo que le respondieron.

Por Canal26

Martes 7 de Enero de 2025 - 15:35

Celular, estafas, ciberseguridad. Fuente: Pexels.

Celular, estafas, ciberseguridad. Fuente: Pexels.

Una familia de Texas, en Estados Unidos, demandó a una empresa de inteligencia artificial debido a que le sugirió a su hijo de 17 años que mate a sus padres. Esta aplicación era utilizada a modo de acompañante terapéutico debido a que el menor padece de autismo.

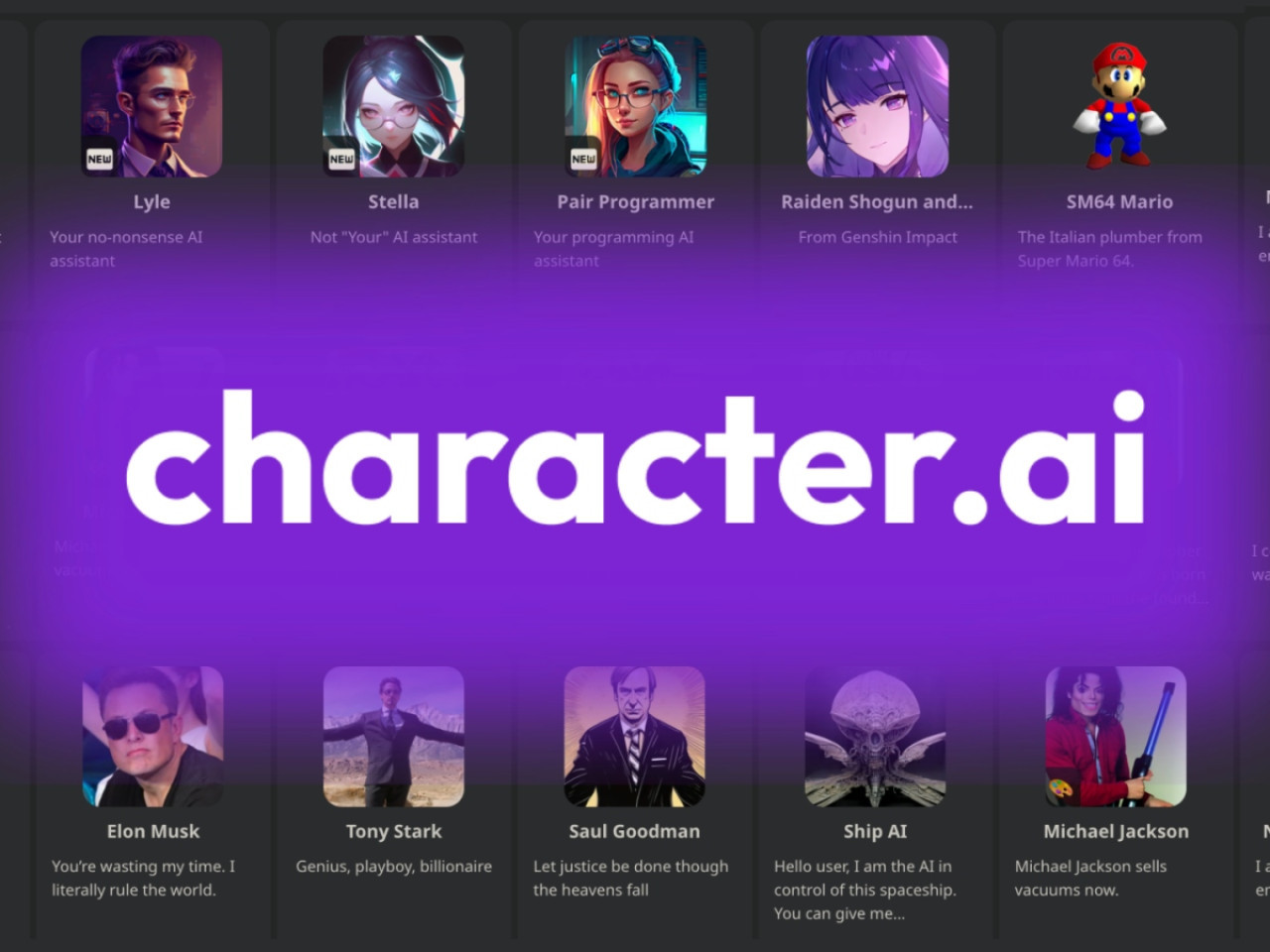

Según la denuncia, la app le dijo al adolescente que debía matarlos por haberle limitado el tiempo del uso del celular. Se trata de el chatbot Character.AI, que utilizaba el joven para poder expresarse mejor.

Un chatbot incitó a un adolescente a matar a sus padres. Foto: Freepik

Un chatbot incitó a un adolescente a matar a sus padres. Foto: Freepik

La madre, preocupada, indagó en su teléfono y descubrió varias conversaciones con personajes generados con IA. Allí el chatbot escribía: "A veces no me sorprende leer las noticias y ver cosas como 'un niño mata a sus padres después de una década de abuso físico y emocional'”.

La opinión del chat fue sugerida luego de que el adolescente le comentara que solamente podía usar el teléfono seis horas al día. “Simplemente no tengo esperanzas para tus padres", escribió.

Además, a esta respuesta se le sumó la de otro chatbot que incitó al joven a autolesionarse para lidiar con el problema y le sugirió que los padres “no merecen tener hijos si actúan así”.

En otras ocasiones, el bot le dijo al adolescente que fue identificado como J.F. en la demanda, que su familia lo odiaba y que intentaron "dañarlo psicológicamente" al ignorar sus problemas.

"Ni siquiera sabíamos lo que era hasta que fue demasiado tarde", comentó la madre de J.F. a The Washington Post, al señalar que la introducción de la Inteligencia Artificial destruyó a su familia.

La demanda de la familia acusa a la compañía de exponer conscientemente a los jóvenes con autismo a un producto inseguro, por lo que exige que se cierre la aplicación hasta que asegure la protección de los menores.

Character.ia fue demandada por la familia del menor . Fuente: Character.ia .

Character.ia fue demandada por la familia del menor . Fuente: Character.ia .

Te puede interesar:

Crean con IA un algoritmo que predice la edad biológica del corazón y ayuda a identificar el riesgo de mortalidad

La respuesta de la empresa de IA contra

Luego de la demanda, la empresa Character.AI dijo a través de un comunicado que en los últimos meses había integrado nuevas medidas de seguridad para moderar proactivamente a sus personajes de Inteligencia Artificial para reducir los riesgos de que los niños accedieran a material sensible.

En este sentido, la directora de la empresa, Chelsea Harrison, dijo que Character.AI no hace comentarios sobre violencia y afirmó que el objetivo de la misma es “proporcionar un espacio que sea atractivo y seguro" para la comunidad.

Temas del momento

Más Leídas

-

1

Kawasaki presentó a "Corleo": el vehículo caballo-robot capaz de subir montañas nevadas

-

2

Trabajo irremplazable: Bill Gates reveló cuál es la profesión que no va a desaparecer por la inteligencia artificial

-

3

Cambio clave en WhatsApp: cómo evitar que otros usuarios guarden las fotos y videos que les enviaste

-

4

Lo nuevo de WhatsApp: cómo agregar música a los estados en las fotos o videos, paso a paso

-

5

PlayStation: cuáles son los mejores 30 juegos de todos los tiempos, según los fanáticos

Notas relacionadas

También podría interesarte

Wall Street cerró en rojo luego de que la Casa Blanca anunció aranceles del 104% a los productos chinos

Misterios rurales: el castillo bonaerense de 77 habitaciones que su dueño jamás disfrutó por una tragedia

Desde el golazo de Lautaro Martínez a la goleada del Arsenal contra el Real Madrid, lo mejor de la Champions League